跳至内容

AI,是artificial intelligence的缩写。

Artificial,很多同学认字认半边,会以为是艺术(art)的什么形容词。其实不然,artificial的意思就是“人工的、人造的”,和natural(天然的)是反义词。

Intelligence,这个不容易认错,是“智能”的意思。英特尔(Intel)公司的名字,就是基于这个词的前五个字母。

结合起来,AI,就是“人工的、人造的智能”,用人为的手段,创造智能。

关于AI的定义,行业里有很多种说法。比较学术化的一种,是这么说的:

AI,是研究、开发用于模拟、延伸和扩展人的智能行为的理论、方法、技术及应用系统的一门综合性科学。

首先,AI的本质属性,是一门科学,是一个技术领域。

它涉及到了计算机科学、数学、统计学、哲学、心理学等多种学科的知识,但总体上,归类于计算机学科之下。

这个“系统”,可以是一套软件程序,也可以是一台计算机,甚至是一个机器人。

这是问题的关键。目前看来,能够像人一样感知、理解、思考、判断、决策,就是实现了人工智能。

配合机器人、机械臂等物理载体,AI也可以实现行动能力。

AI,目前仍然是基于计算机的基本玩法,采用的是半导体芯片技术(所以经常会被称为“硅基”),以及计算机的一些体系和平台。

传统的计算机程序,就是一个规则的集合。程序员通过代码告知计算机规则,计算机根据规则,对输入数据进行判断和处理。

例如经典的“if……else……(如果……否则……)”语句——“如果大于65岁,就退休。否则,继续上班”。

然后,计算机程序会根据这个规则,对所有输入年龄数据进行判断和处理。

但是,在现实生活中,很多要素(例如图像和声音)是极为复杂和多样的,我们很难给出固定的规则,让计算机实现高准确率的判断和处理。

狗有很多品种,每种狗有不同的颜色、体型、五官特征。狗在不同的时间,也有不同的表情、姿势。狗还会处于不同的背景环境下。

所以,计算机通过摄像头捕捉到的狗的影像,是无穷尽的。很难通过有限数量的规则,去帮助计算机做出判断。

想要让计算机实现像人一样的智能,不能采用简单的规则驱动,而是应该像教孩童一样,不断输入数据和答案,让他自行总结特征,形成自己的判断规则。

换言之,在经典的程序设计中,人们输入的是规则(即程序)和数据,系统输出的是答案。

第一个步骤,输入的是数据和预期得到的答案,系统输出的是规则。

第二个步骤,将输出的规则应用于新的数据,然后再输出答案。

第一步,我们可以称之为“训练”。第二步,才是真正“干活”。

这就是传统计算程序和现在主流AI技术的一个典型区别。(注意,我说的是“现在主流AI”。有一些“历史AI”和“非主流AI”,玩法不一样。不能一概而论。)

从1950年代正式诞生以来,围绕人工智能,已经有很多科学家进行了大量的研究,也输出了很多非常了不起的成果。

这些研究,根据思路方向的不同,被分为了很多种学派。比较有代表性的,是符号主义学派、联结主义学派、行为主义学派。

这些学派并没有对错之分,相互之间也有一些交叉融合。

早期的时候(1960-1990),符号主义(以专家系统、知识图谱为代表)是主流。后来,从1980年开始,联结主义(以神经网络为代表)崛起,一直到现在,都是主流。

将来,也许有新的技术崛起,形成新的学派,也不一定。

除了方向路线之外,我们也可以从智能水平以及应用领域等方面对AI进行分类。

按智能水平,可以分为:弱人工智能(Weak AI)、强人工智能(Strong AI)、超人工智能(Super AI)。

弱人工智能只专精于单一任务或一组相关的任务,不具备通用智能能力。我们目前就处于这个阶段。

强人工智能更厉害一些,具有一定的通用智能能力,能够理解、学习并应用于各种不同的任务。这个还处于理论和研究阶段,还没落地。

超人工智能当然是最强的。它在几乎所有方面都超过人类智能,包括创造力、社交技能等。超人工智能是未来的终极形态,我们假设它能够实现。

其实我们前面介绍规则总结的时候,其实已经提到了机器学习。

机器学习的核心思想,是构建一个可以从数据中学习的模型,并利用这个模型来进行预测或决策。

机器学习不是一个具体的模型或算法。它包括了很多种类型,例如:

监督学习:算法从带有标签的数据集中学习,即每个训练样本都有一个已知的结果。

半监督学习:结合了少量的带标签数据和大量的未带标签数据进行训练。

强化学习:通过试错的方式,学习哪些行为可以获得奖励,哪些行为会导致惩罚。

深度学习是机器学习的一个重要分支。机器学习底下有一条“神经网络”路线,而深度学习,是加强版的“神经网络”学习。

神经网络是联结主义的代表。顾名思义,这个路线是模仿人脑的工作原理,建立神经元之间的联结模型,以此实现人工神经运算。

深度学习所谓的“深度”,是神经网络中“隐藏层”的层级。

经典机器学习算法使用的神经网络,具有输入层、一个或两个“隐藏层”和一个输出层。

深度学习算法使用了更多的“隐藏层”(数百个)。它的能力更加强大,让神经网络能够完成更困难的工作。

机器学习、神经网络和深度学习的关系,通过下面的图可以看出:

神经网络从1980年代开始崛起之后,就形成了很多的模型和算法。不同的模型和算法,有着各自的特性和功能。

卷积神经网络(Convolutional Neural Network,CNN)和循环神经网络(Recurrent Neural Network,RNN),是1990年代左右诞生的比较知名的神经网络模型。

卷积神经网络(CNN)是一种用于处理具有类似网格结构的数据(例如图像和视频)的神经网络。所以,它通常用于计算机视觉中,可以用来图像识别和图像分类。

而循环神经网络(RNN)是一种用于处理序列数据的神经网络,例如语言模型和时间序列预测。所以,它通常用于自然语言处理和语音识别。

transformer也是一个神经网络模型。它比卷积神经网络和循环神经网络更加年轻(2017年由谷歌研究团队提出),也更加强大。

作为非专业人士,不需要去研究它的工作原理,只需要知道:

2、它使用了一种名为自注意力(self-attention)的机制;

3、它有效解决了卷积神经网络和循环神经网络的瓶颈(局限性)问题;

4、它很适合自然语言处理(NLP)任务。相比循环神经网络,它的计算可以高度并行化,简化了模型架构,训练效率也大大提升;

5、它也被扩展到了其他领域,如计算机视觉和语音识别。

6、现在我们经常提到的大模型,几乎都是以transformer为基础。

这两年AI火,就是因为大模型火。那么,什么是大模型?

大模型,是具有庞大参数规模和复杂计算结构的机器学习模型。

参数,是指在模型训练过程中,学习和调整的变量。参数定义了模型的行为、性能、实现的成本以及对计算资源的需求。简单来说,参数是模型内部用来做出预测或决策的部分。

大模型,通常拥有数百万至数十亿的参数。相对应的,参数少的,就是小模型。对一些细分的领域或场景,小模型也够用。

大模型需要依赖大规模数据进行训练,对算力资源的消耗极大。

大模型有很多种类别。通常所说的大模型,主要是指语言大模型(以文本数据进行训练)。但实际上,还有视觉大模型(以图像数据进行训练),以及多模态大模型(文本和图像都有)。

绝大多数大模型的基础核心结构,都是Transformer及其变体。

按应用领域,大模型可以分为通用大模型和行业大模型。

通用大模型的训练数据集更加广泛,覆盖的领域更加全面。行业大模型,顾名思义,训练数据来自特定行业,应用于专门的领域(例如金融、医疗、法律、工业)。

GPT-1、GPT-2……GPT-4o,等等,都是美国OpenAI这家公司推出的语言大模型,同样都是基于Transformer架构。

GPT的全称,叫做Generative Pre.trained Transformer,生成式-预训练-Transformer。

Generative(生成式),表示该模型能够生成连续的、有逻辑的文本内容,比如完成对话、创作故事、编写代码或者写诗写歌等。

这里刚好提一下,现在常说的AIGC,就是AI Generated Content,人工智能生成内容。内容,可以是文本、图像、音频、视频等。

文生图,比较有代表性的是DALL·E(也来自OpenAI)、Midjourney(知名度大)和Stable Diffusion(开源)。

文生音频(音乐),有Suno(OpenAI)、Stable Audio Open(由Stability.ai开源)、Audiobox(Meta)。

文生视频,有Sora(OpenAI)、Stable Video Diffusion(由Stability.ai开源)、Soya(开源)。图也可以生视频,例如腾讯的Follow-Your-Click。

AIGC是一个“应用维度”的定义,它不是一个具体的技术或模型。AIGC的出现,扩展了AI的功能,打破了此前AI主要用于识别的功能限制,拓宽了应用场景。

好了,继续解释GPT的第二个字母——Pre.trained。

Pre.trained(预训练),表示该模型会先在一个大规模未标注文本语料库上进行训练,学习语言的统计规律和潜在结构。

通过预训练,模型才有了一定的通用性。训练的数据越庞大(如网页文本、新闻等),模型的能力就越强。

大家对于AI的关注热潮,主要源于2023年初的ChatGPT爆火。

ChatGPT的chat,是聊天的意思。ChatGPT是OpenAI基于GPT模型开发的一个AI对话应用服务(也可以理解为GPT-3.5)。

通过这个服务,人们才可以亲身体验到GPT模型的强大,有利于技术的宣传和推广。

事实证明,OpenAI的策略成功了。ChatGPT充分吸引了公众关注度,也成功推动了AI领域的发展热潮。

概括来说,AI和传统计算机系统相比,能提供的拓展能力,包括:图像识别、语音识别、自然语言处理、具身智能等方面。

图像识别,有时候也被归类为计算机视觉(Computer Vision,CV),让计算机具备理解和处理图像和视频的能力。常见的是摄像头、工业质检、人脸识别之类的。

语音识别,就是理解和处理音频,获得音频所搭载的信息。常见的是手机语音助手、电话呼叫中心、声控智能家居之类的,多用于交互场景。

自然语言处理,前面介绍过,就是使计算机能够理解和处理自然语言,知道我们到底在说什么。这个很火,多用于创造性的工作,例如写新闻稿、写书面材料、视频制作、游戏开发、音乐创作等。

具身智能,就是把人工智能搭载在一个物理形态(“身体”)上,通过与环境互动,来获得和展示智能。

斯坦福大学年初推出的“Mobile ALOHA”,就是一个典型的家用具身机器人。它可以炒菜、煮咖啡甚至逗猫,火爆全网。

值得一提的是,并不是所有的机器人,都是人形机器人。也不是所有的机器人,都用到了AI。

人形机器人

AI特别擅长对海量数据进行处理,一方面通过海量数据进行学习和训练,另一方面,基于新的海量数据,完成人工无法完成的工作。或者说,找到海量数据中潜在的规律。

目前AI在社会各个垂直行业的应用,主要是围绕上面的能力进行延展。

在医疗领域,AI已经可以用于分析X光片、CT扫描、MRI图像等,帮助识别识别异常区域,甚至做出诊断判断。AI还可以用于识别组织切片中的细胞变异,辅助病理学家进行癌症筛查和其他疾病的诊断。

AI还可以分析患者的基因组数据,确定最适合的治疗方案。AI也可以根据患者的病史和生理指标,辅助预测病情趋势。

在药品研发方面,AI可以帮助模拟化学成分的相互作用,缩短新药研发周期。

发生严重的公共卫生事件时,AI可以分析流行病数据,预测疾病传播的趋势。

在金融领域,AI可以实时监测市场动态,识别潜在的市场风险,并制定相应的风险对冲策略。

AI还可以通过分析借款人的信用记录、收入情况、消费行为等多维度数据,评估信贷风险。当然,AI也可以结合投资者的个人财务情况、风险偏好和收益目标,提供最合适的投资组合建议。

类似的例子实在是数不胜数。在工业制造、教育文旅、商业零售、农林牧渔、公共安全、政府治理等几乎所有领域,AI都已经有了实际的落地场景和案例。

AI的商业和社会价值,是毋庸置疑的。它的崛起趋势,也是不可阻挡的。

从企业的角度来说,AI能够自动化重复性、繁琐的任务,提高生产效率和质量,同时降低生产成本和人力成本。

对于制造业和服务业来说,这个优势至关重要,直接影响了企业的竞争力,甚至是生存。

从政府的角度来说,AI不仅可以提升治理效率,也能够带来新的商业模式、产品和服务,刺激经济。

人形机器人

AI特别擅长对海量数据进行处理,一方面通过海量数据进行学习和训练,另一方面,基于新的海量数据,完成人工无法完成的工作。或者说,找到海量数据中潜在的规律。

目前AI在社会各个垂直行业的应用,主要是围绕上面的能力进行延展。

在医疗领域,AI已经可以用于分析X光片、CT扫描、MRI图像等,帮助识别识别异常区域,甚至做出诊断判断。AI还可以用于识别组织切片中的细胞变异,辅助病理学家进行癌症筛查和其他疾病的诊断。

AI还可以分析患者的基因组数据,确定最适合的治疗方案。AI也可以根据患者的病史和生理指标,辅助预测病情趋势。

在药品研发方面,AI可以帮助模拟化学成分的相互作用,缩短新药研发周期。

发生严重的公共卫生事件时,AI可以分析流行病数据,预测疾病传播的趋势。

在金融领域,AI可以实时监测市场动态,识别潜在的市场风险,并制定相应的风险对冲策略。

AI还可以通过分析借款人的信用记录、收入情况、消费行为等多维度数据,评估信贷风险。当然,AI也可以结合投资者的个人财务情况、风险偏好和收益目标,提供最合适的投资组合建议。

类似的例子实在是数不胜数。在工业制造、教育文旅、商业零售、农林牧渔、公共安全、政府治理等几乎所有领域,AI都已经有了实际的落地场景和案例。

AI的商业和社会价值,是毋庸置疑的。它的崛起趋势,也是不可阻挡的。

从企业的角度来说,AI能够自动化重复性、繁琐的任务,提高生产效率和质量,同时降低生产成本和人力成本。

对于制造业和服务业来说,这个优势至关重要,直接影响了企业的竞争力,甚至是生存。

从政府的角度来说,AI不仅可以提升治理效率,也能够带来新的商业模式、产品和服务,刺激经济。

强大的AI,也是一种国家竞争力。在科技博弈和国防事业方面,如果AI技术不如别人,可能会带来严重后果。

从个人的角度来说,AI可以帮助我们完成一些工作,也可以提升我们的生活品质。

从整个人类的角度来说,AI在疾病治疗、灾害预测、气候预测、消灭贫穷方面,也可以发挥重要的作用。

但事物都是有两面性的。AI作为工具,既有利,也有弊。

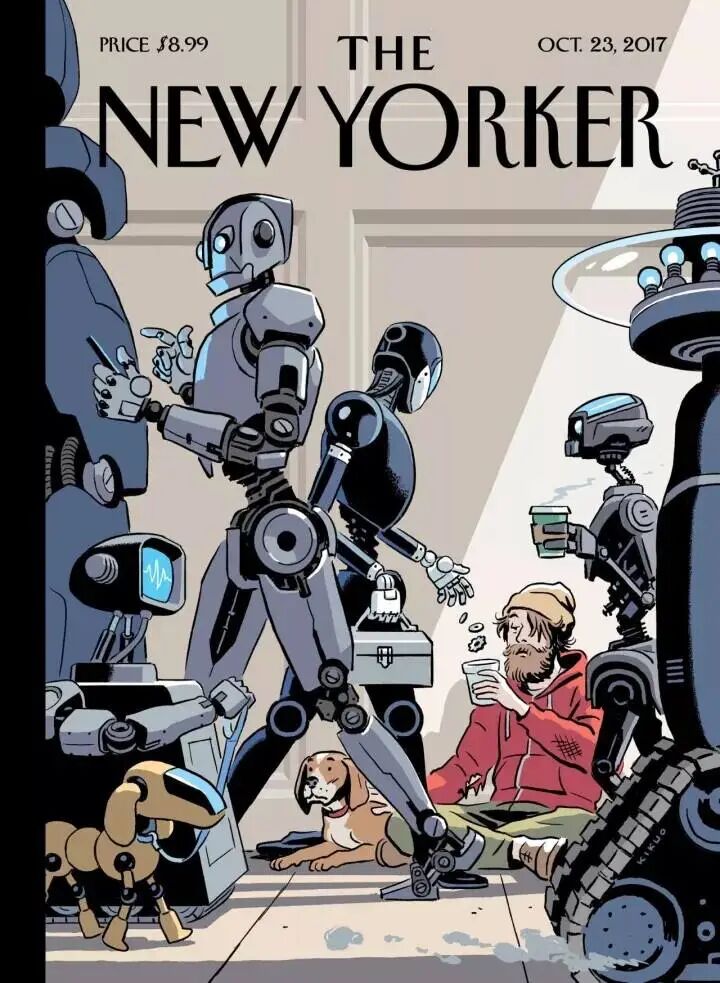

最现实的一个弊,就是可能会威胁到大量的人类工作岗位,导致大量失业。根据麦肯锡的研究,到2030年至2060年之间,大约50%的职业可能会逐步被AI取代,特别是对于知识工作者而言。

图片来自《纽约客》杂志

除此之外,AI被用于发动战争、欺诈(模仿声音或换脸,进行诈骗)、侵犯公民权益(信息过度采集、侵犯隐私)。

如果只有少数公司拥有先进的AI技术,可能会加剧社会的不公平现象。AI的算法偏见,也可能导致不公平。

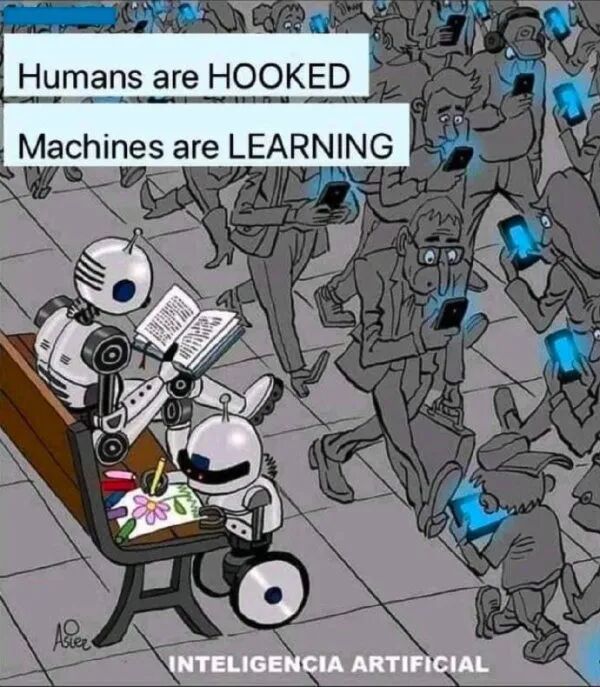

AI变得越来越强大,也会让人们产生对AI的依赖,失去独立思考和解决问题的能力。AI的强大创造力,有可能让人类失去创造的动力和信心。

围绕AI的发展,还有安全(数据泄露、系统崩溃)、道德伦理等一系列问题。

所有这些问题,我们目前都没有靠谱的解决方案。所以,只能在发展AI的过程中,一点点去探索、思考和解决。对于AI的警惕和防范之心,是一定要有的。

作为我们普通人,目前最现实的做法,就是先了解它、学习它。先学会使用常见的AI工具和平台,帮助自己提升工作效率,改善生活品质。

有句话说的好:“未来,淘汰你的不是AI,而是掌握了AI的人”。与其焦虑,不如勇敢面对和积极拥抱,尽早掌握主动权。

好啦,以上就是今天文章的全部内容。对于一个普通人来说,知道这些AI常识,就是拥抱AI的第一步。至少和别人聊天的时候,谈到AI,就不会一头雾水了。